Если вы запускаете сканирование сайта – вы можете значительно повысить производительность работы SiteAnalyzer, выполнив следующие действия.

1. Во-первых, какого размера сайт вы сканируете?

- 1-1000 страниц – небольшой объем для сканирования. Можно запустить его через функцию Fast Crawl на большинстве ПК без изменения каких-либо настроек.

- 1к-50к страниц – все еще не существенный объем – большинство компьютеров просканируют сайт без проблем и без изменений конфигурации, хотя вам понадобится не менее 2-3 ГБ свободного места на диске.

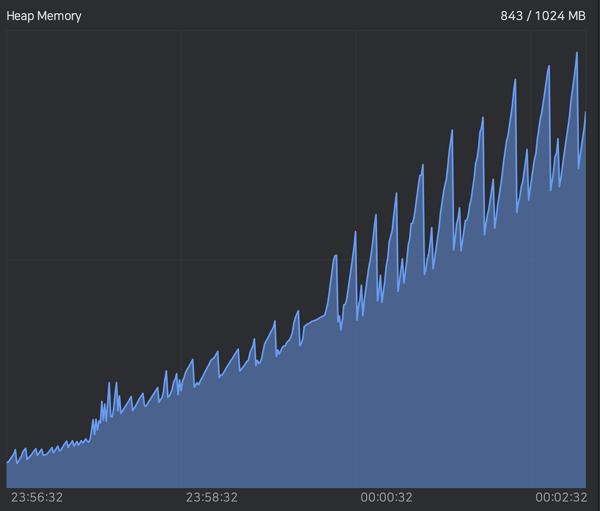

- 50к-100к страниц – достаточно масштабный краулинг. Здесь можно изменить режим сканирования в SiteAnalyzer с виртуального на проектное (хранение данных в базе на жестком диске) – лучше хранить базу на внешнем SSD диске, если это возможно.

- 500к+ страниц – работа через список проектов, по возможности используйте внешний диск. Измените выделение памяти таким образом, чтобы зарезервировать свободные 10+ ГБ ОЗУ.

- 1млн+ страниц – рекомендуем взять мощный ПК, желательно стационарный с не менее 32 Гб ОЗУ, на котором можно выделить большую часть ресурсов непосредственно для сканирования.

2. Сканирование сайта без лишних параметров

Подумайте, действительно ли вам нужно сканировать все URL-адреса?

Если у вас динамический сайт со множеством параметров URL, это может значительно увеличить количество сканируемых URL без добавления какой-либо ценности.

Если это так, определите, какие переменные / параметры позволяют масштабировать сканирование.

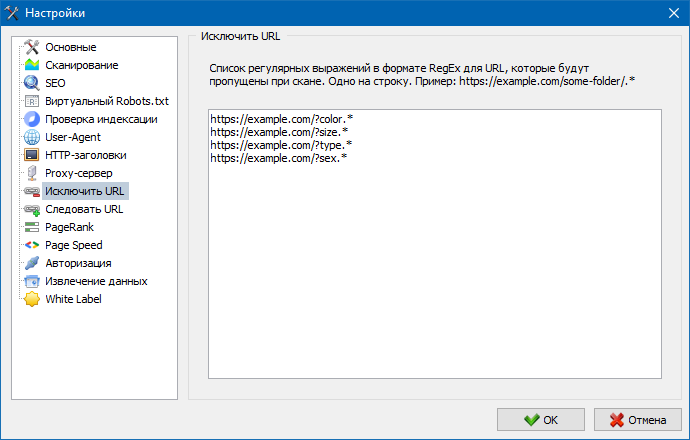

Также, в разделе «Настройки > Исключить URL», используйте регулярное выражение, чтобы исключить часть пути URL, т.е. параметры ?s= / ?= и т.п.

Если у вас большой сайт с многочисленными параметрами, можно использовать списки фильтрации для исключения URL с параметрами, т.е.:

- https://example.com/?color

- https://example.com/?size

- https://example.com/?type

- https://example.com/?sex

- и т.д.

3. Сканирование сайта по частям

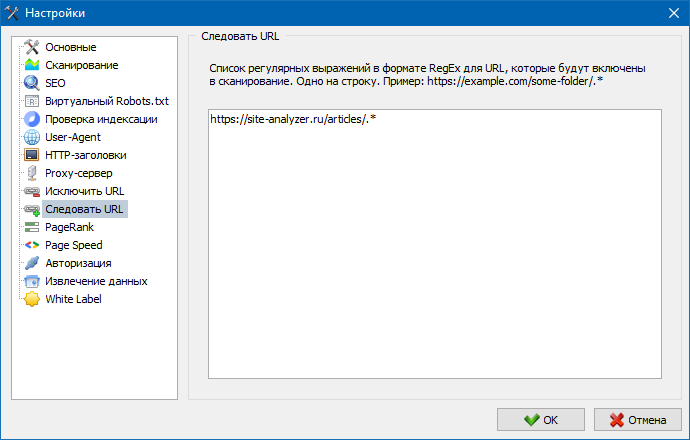

Подумайте о создании нескольких сегментированных обходов сайта – это отлично подходит для больших сайтов, если вы не хотите ждать сканирование сайта целиком до бесконечности.

Мы рекомендуем настроить сканирование, используя подпапку в качестве основы сканирования, затем убедится, что в настройках SiteAnalyzer вы установили следовать URL для включения в путь к вашей подпапке – таким образом, будут сканироваться только URL-адреса в этой подпапке.

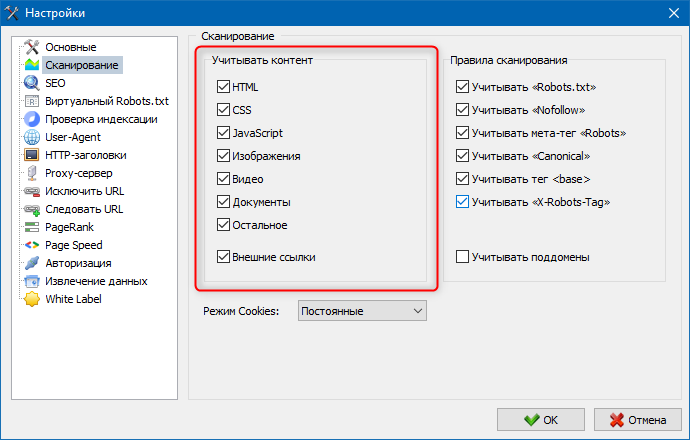

4. Сведения о странице

В разделе «Настройки > Сканирование > Учитывать контент» – снимите флажки с изображений / CSS / JS и т.п. Можно снять все, кроме HTML.

Приведенные выше решения должны помочь вам выполнять более грамотные обходы вашего сайта!

Другие статьи:

3,367

3,367