Всем привет! В новой версии SiteAnalyzer добавлена возможность виртуального сканирования сайтов (функция «Virtual Crawl»), добавлено отображение правил файла Robots.txt для запрещенных к индексации страниц, а также добавлено описание ошибок, отображаемых по фильтрам вкладки «Статистика SEO». Рассмотрим подробнее детали новой версии.

Основные изменения

1. Виртуальное сканирование сайтов

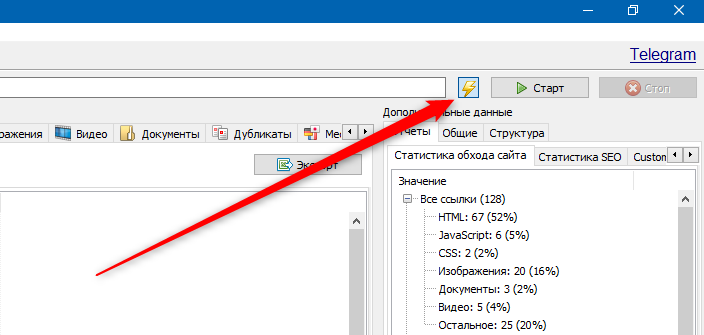

Виртуальное сканирование «Virtual Crawl» реализовано за счет сканирования сайтов без использования базы данных за счет чего нивелируются потери при взаимодействии сканера с базой данных программы и сканирование происходит на порядок быстрее на медленных HDD или SSD дисках. Все данные при этом хранятся виртуально и доступны только во время запуска программы и до переключения на другой проект.

Виртуальное сканирование реализовано через переключатель, расположенный рядом с кнопками «Старт» и «Стоп» в верхней части программы.

- При отжатом переключателе, сайты сканируются в классическом режиме.

- При нажатом переключателе, сайты сканируются в режиме виртуального сканирования.

Плюсы и минусы режима «Virtual Crawl»:

- Минусом данного режима является то, что данные по проекту актуальны лишь на момент работы программы и до переключения на другой проект.

- При этом плюсом является быстрое добавление и анализ проекта, а также увеличение скорости сканирования на медленных HDD или SSD дисках.

- Результаты сканирования в режиме «Virtual Crawl» полностью дублируют функционал сканирования по списку проектов (фильтры, выборки, граф визуализации и т.п.).

Примечание. Режим «Virtual Crawl» доступен только на платном тарифе.

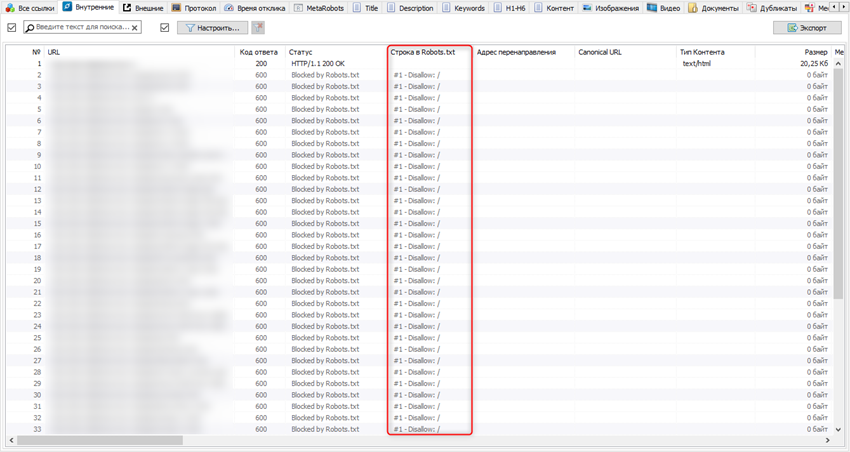

2. Правила Robots.txt для запрещенных к индексации страниц

По просьбам пользователей, было добавлено отображение правил файла Robots.txt для запрещенных к индексации страниц.

Теперь SiteAnalyzer автоматически определит страницы, которые блокируются в файле Robots.txt, а также отобразит правило, запрещающее их индексацию.

Это действительно удобный и наглядный отчет, который позволяет проводить аудит файла Robots.txt. Часто владельцы сайтов проверяют URL один за другим, чтобы увидеть, блокируются ли они через файл Robots.txt. Таким образом, в отличии от не совсем удобных «ручных» тестов, вы можете провести массовый анализ URL, чтобы убедиться, что исключения в Robots.txt работают должным образом.

Как это проверить в SiteAnalyzer:

1. Запустите SiteAnalyzer.

2. Просканируйте интересующий сайт.

3. После завершения сканирования, перейдите на вкладку «Внутренние > Строка в Robots.txt».

4. Теперь вы можете увидеть все страницы, заблокированные файлом Robots.

5. В столбце «Строка в Robots.txt» будет указан номер строки и правило, блокирующее сканирование данного URL.

Это бывает полезно, если у вас большой сайт с большим количеством сложных правил Robots. Тестирование одного за другим URL может быть полезным, но также сложным для понимания того, как определенное правило применяется ко всему сайту. Данная функциональность по сути позволит вам протестировать файл Robots.txt в масштабе всего сайта.

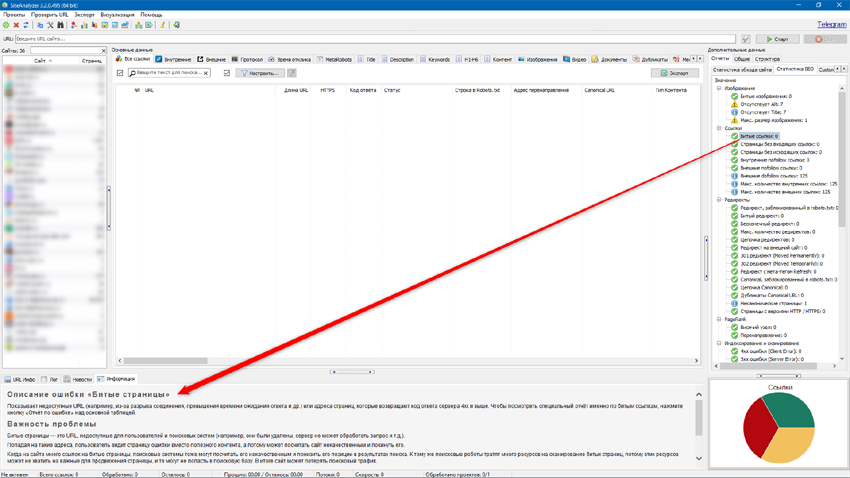

3. Подробные описания ошибок по SEO-фильтрам

Для лучшего понимания работы фильтров вкладки «Статистика SEO» на нижней панели было добавлено подробное описание ошибок по каждому из соответствующих фильтров (вкладка «Информация»), а также указаны возможные причины возникновения ошибок и, по возможности, рекомендации по их устранению.

Прочие изменения

- Исправлена некорректная работа прокси при запуске программы и проверке лицензионного ключа.

- Увеличено максимально возможное значение параметра «Таймаут запроса» до 3600 секунд.

- Виртуальный Robots.txt стал индивидуальным для каждого сайта.

Будем рады любым замечаниям и предложениям по работе и развитию функционала программы.

***

Отслеживайте все обновления программы SiteAnalyzer на нашем Телеграм-канале! https://t.me/siteanalyzer

До новых встреч!

Новости прошлых версий:

4,134

4,134