Этот пост символический майлстоун уходящего года и мысли какими должны быть аффилиатные сайты под Amazon и другие партнерки, которыми мы в AdmixGlobal занимаемся последние несколько лет.

Часть 1

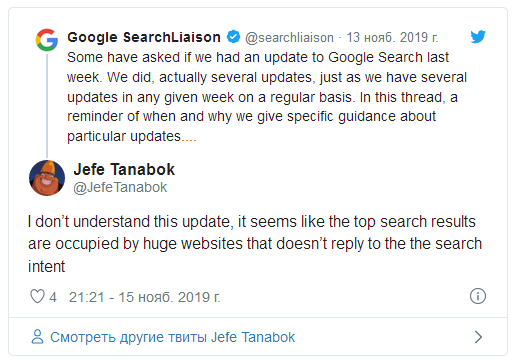

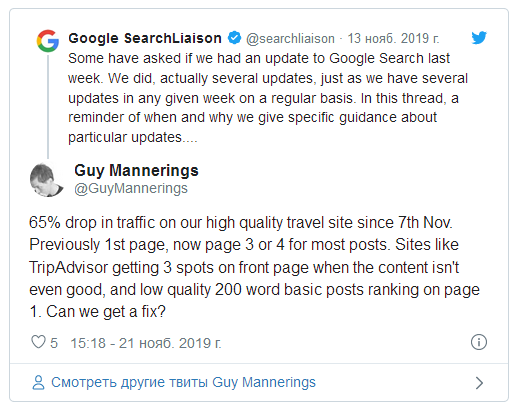

7 ноября 2019 произошел апдейт алгоритма и хотя в Google заявляют, что это обычный регулярный апдейт, значительное (от 30%) падение одних сайтов и рост других говорит о том, что произошло нечто существенное.

Часть вебмастеров сообщают, что их сайты были вытеснены более крупными и авторитетными ресурсами.

Свое видение написал и Дмитрий Угниченко (Dmytro Ugnichenko) из компании Megaindex в статье "SEO под низкочастотные (НЧ) запросы больше работать не будет? Google применил алгоритм BERT на все запросы".

Вот несколько цитат:

- Внимание. Теперь текст будет анализироваться не с точки зрения вхождения слов, а по смыслу. Иными словами, теперь будет анализироваться так называемое смысловое соответствие.

- Метод продвижение сайта по низкочастотным запросам может перестать быть эффективным. Преимущество над такими сайтами будут иметь авторитетные сайты, на которых нет оптимизации под низкочастотные запросы.

- Что делать? Сначала на сайте следует уменьшать объем страниц. К примеру, если на сайте есть страница с iPhone, который предлагается в разных цветах, то нет смысла создавать страницу под каждый цвет. Такие страницы следует свести к общей странице. На всех исключенных из использования URL следует разместить либо 301 редирект, либо тег rel=canonical.

Если это алгоритм BERT, который призван понимать содержимое документа, то по идее в топе Google должны оказаться страницы, заточенные под низкочастотные запросы, но во многих случаях произошло как раз наоборот.

Определенное замешательство зреет и в среде аффилиатов амазона. Как делать сайты? Будут ли работать сайты, заточенные под низкочастотные запросы?

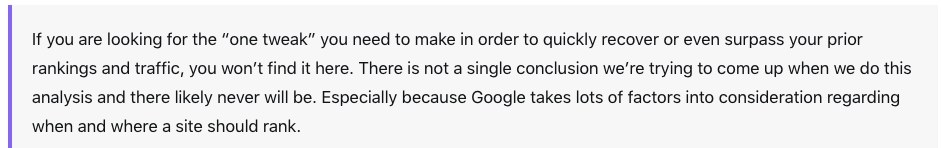

Нет однозначных выводов пока и у таких известных спецов, как Glen Allsopp.

После анализа 50 дропнувшихся сайтов, в одном из апдейтов своего курса SEO Blueprint, он написал следующее:

Glen Allsopp из Gaps.com

Наличие более десятка своих и партнерских сайтов, при построении и продвижении которых мы используем разные подходы, а также наблюдение за проданными сайтами помогает нам делать определенные выводы.

За последний месяц мы с ребятами проанализировали более сотни "упавших" и "выросших" сайтов.

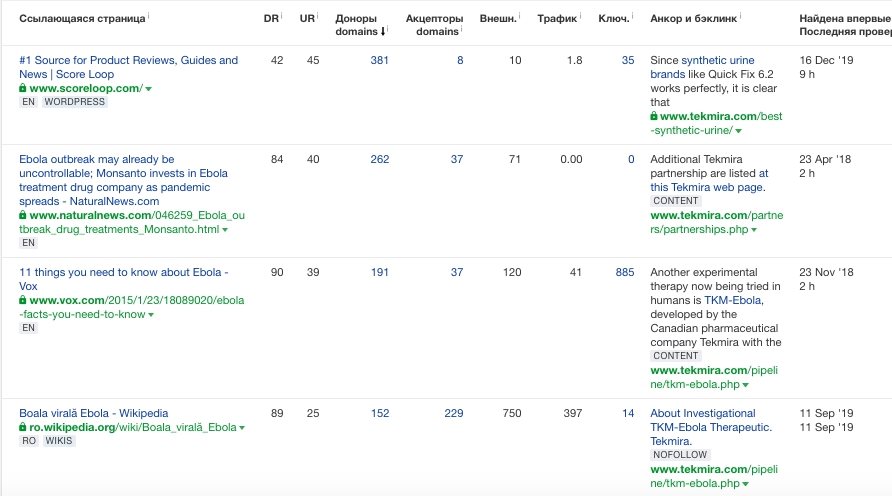

И если каким-то сайтам можно приписать проблемы с ссылками, использование редиректов, PBN, как например у сайта bestcarseathub.com, то существует достаточное число сайтов с хорошим контентом, которые продвигались аутричем и падение трафика стало неприятным сюрпризом для их владельцев.

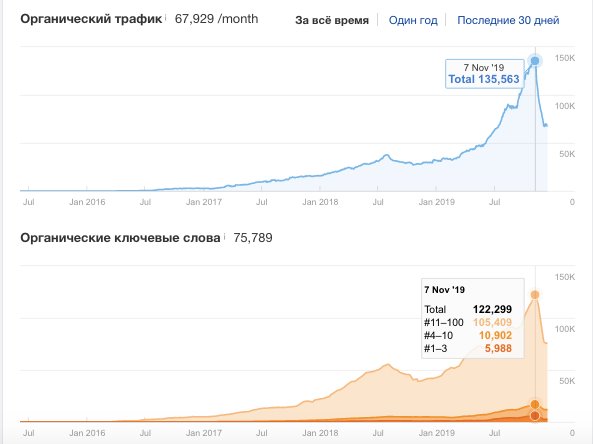

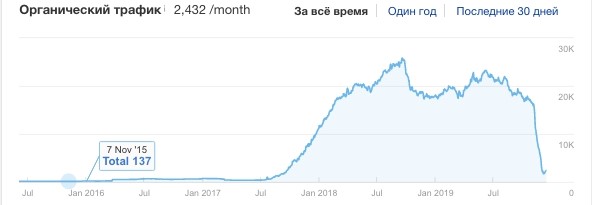

Один из таких сайтов – coolofthewild.com.

Трафик у coolofthewild стабильно рос, а после на 7 ноября резко обвалился.

На сайт ведут сотни ссылок с авторитетных ресурсов, за сайтом стоят реальные авторы, они ведут канал на youtube, у них есть подписчики в соцсетях, ребята рисуют инфографики, сайт содержит не только коммерческий контент (статьи с ссылками на Amazon), но и информационные статьи.

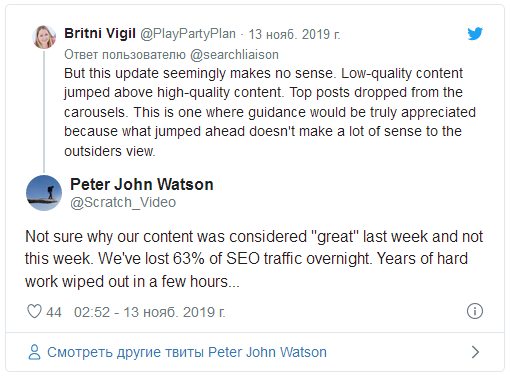

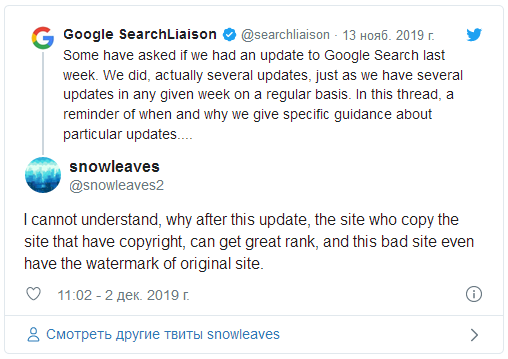

Часть вебмастеров сообщают, что в топах Google появился и контент низкого качества.

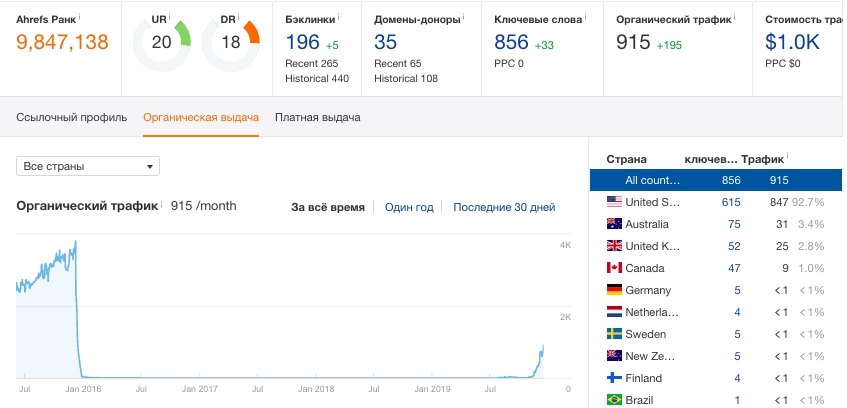

И действительно, мы нашли достаточно примеров проектов-заброшек, которые не обновлялись много лет, с очень слабым контентом, но после апдейта эти проекты ожили. На скриншоте ниже EMD домен и всего 5 статей с аффилиатным контентом.

Что нам удалось обнаружить:

- Трафик у дропнувшихся сайтов просел неравномерно, у части страниц рост продолжается. Хотя страница в индексе, контент вы писали сами, Google может считать вашу страницу рерайтом других источников.

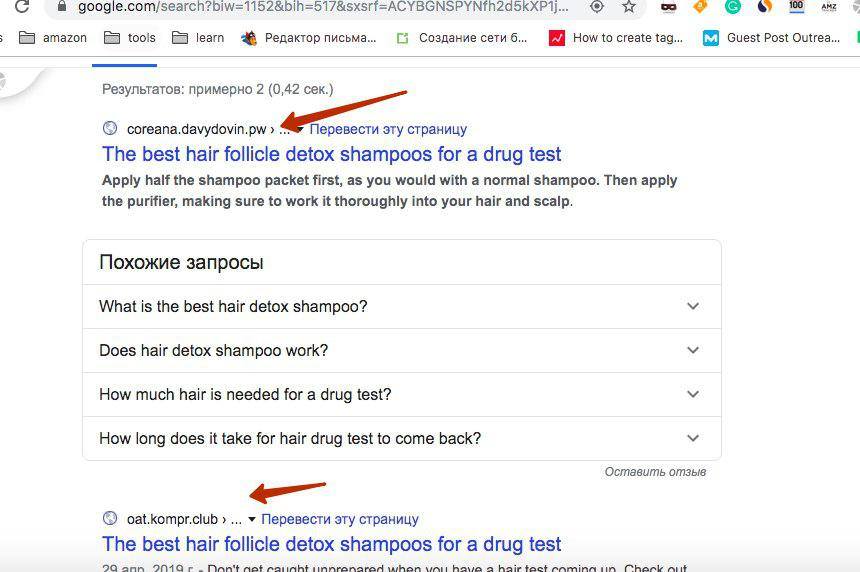

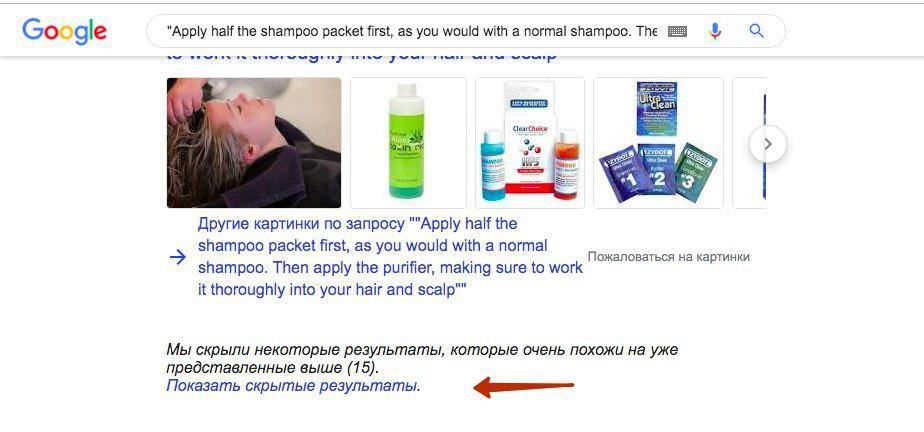

- Если искать в Google фрагменты из ваших статей, забивая отдельные предложения в кавычки, то может обнаружиться, что эти отдельные предложения с вашего сайта скопировали дорвеи и в ряде случаев поисковик перестает считать ваш сайт первоисточником. Об этом пишут и некоторые пользователи.

Я анализировал сайт одного из подписчиков телеграмм канала AmazonPartnerka и часть предложений с его сайта попадали при поиске в Google в "дополнительные результаты", а в основных результатах были взломанные сайты и дорвеи на .tk и .nl доменах.

Что интересно, подавать DMCA жалобы через Google Search Console бесполезно – такие запросы отклоняют, ведь сайт дорвей не копирует значительную часть текста, часто это всего одно предложение. Также во многих случаях на момент проверки сайта модераторами Google дорвейные сайты были уже недоступны.

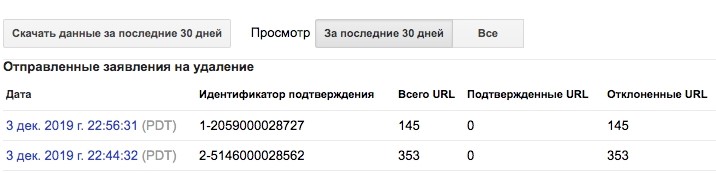

Отклоненные URL

Мы переписали три статьи у нескольких наших сайтов и трафик вернулся.

Перепись контента дала результат и нашему подписчику.

"Привет. Кажется это работает (переписать статью)... Переписал одну, переиндексил, сразу в топ встала. Траф пошел... Если честно, не думал что в этом проблема. Думал, гугл не допустит такой фигни. Когда у тебя контент растаскивают, а ты еще из-за этого и страдаешь...".

Самое плохое в этом то, что так можно валить конкурентов, растаскивая их тексты на ломанные (но более трастовые в глазах Google) сайты.

Правда, риторическим остается вопрос, что делать, когда у вашего сайта 400 страниц как у coolofthewild.com.

А теперь выводы

Мы пришли к заключению, что это был ссылочный апдейт и ноябрьские взлеты и падения сайтов не связаны напрямую с алгоритмом BERT. Произошли изменения в формуле расчета ссылочного траста.

Отныне ссылочный траст разливается между всеми страницами и теперь критично наличие определенного количества ссылок на отдельные документы. Поэтому, например, многостраничные сайты запущенные на expired доменах, без прокачки отдельных страниц ссылками не будут так хорошо расти как раньше, а страница дорвея, прокаченная внешними ссылками может оказаться "трастовее" вашей.

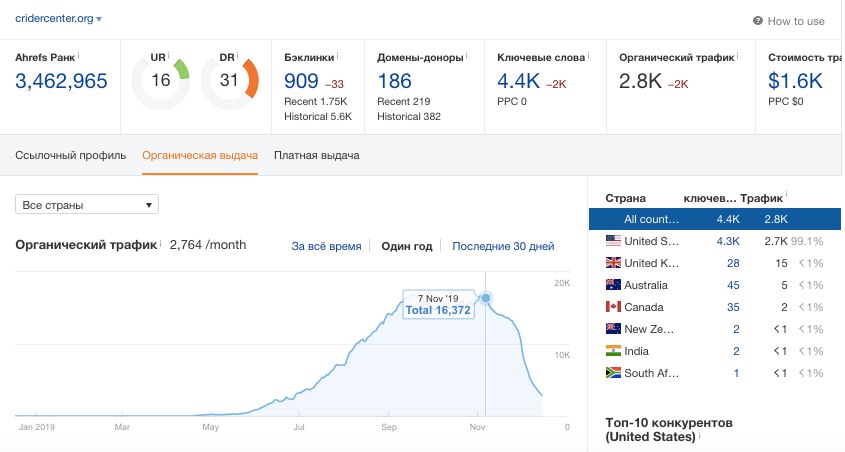

Рассмотрим еще один упавший в ноябре сайт. Проект eco-globe.com был запущен на expired домене. У сайта 300 страниц и после 7 ноября трафик у ресурса обвалился.

Ссылочного траста домена теперь явно недостаточно для всех страниц.

Один из наших просевших сайтов продвигался аутричем, а те кто продвигал сайты гостевыми постами, знают, что вебмастера предпочитают ссылаться не на конкретные посадочные страницы, а на главную – в секции "author bio".

В качестве эксперимента мы удалили 80 страниц с одного из своих многостраничных сайтов. Результат – падение замедлилось, а у части страниц мы сейчас наблюдаем рост. При этом мы не ставили на эти оставшиеся страницы внешние ссылки.

Это не означает, что вам нужно делать микросайты, это означает что вы должны объективно оценивать имеющиеся ресурсы на ссылки.

Попробую провести простую аналогию.

Да, всем нам хочется посадить большой огород (многостраничный сайт), но если у вас нет бочки воды (ссылок), чтоб полить достаточным количеством воды все зеленые насаждения, то часть из них может засохнуть. При наличии ведра воды, лучше посадить пару десятков кустов (страниц), чтобы ваши растения выросли и окрепли.

Часть 2

Часть специалистов отнеслась к моим выводам с определенной долей скептицизма, но давайте исходить из принципа, что никто в точности не знает как работает Google – это черный ящик. Я не претендую на истину в последней инстанции.

Вижу, вижу... доры, плохой pagespeed и два h1

В тоже время, пока ни один известный мне публичный эксперт не дал четкого ответа на вопрос почему после апдейта 7 ноября трафик у ряда сайтов значительно просел, а у других вырос и почему до апдейта некоторые сайты росли стабильно в течение 4-6 лет, а после – провалились.

Понятно, что формула ранжирования это всегда сочетание многих переменных, но какие факторы стали ключевыми в новой версии алгоритма?

Сегодня я рассмотрю конкретный пример, это будет аффилиат сайт не из Amazon ниши.

Сайт запущен на expired домене, с первых чисел мая ресурс рос, но 7 ноября происходит резкая просадка трафика.

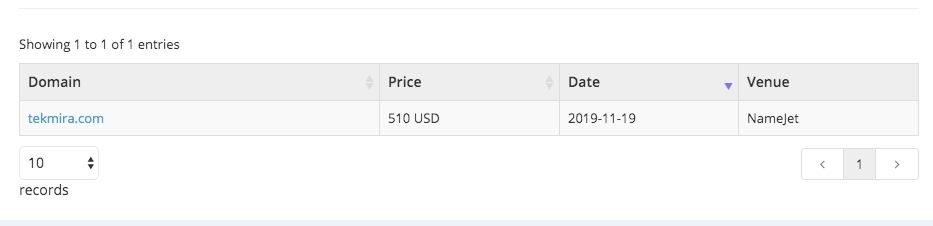

Как часто бывает в таких случаях, владелец данного сайта решает, что поймал фильтр, или теперь у него недостаточно траста, 19 ноября покупает другой expired домен и сразу делает постраничный редирект на этот новый домен.

У нового expired домена много хороших многоуровневых ссылок и свои PBN.

После переезда на "более трастовый" пошел трафик. А дальше...

Дальше запасаемся попкорном.

Видно, что вебмастер достаточно опытен, раз проделывает это все очень быстро и наверняка проделывал такое много раз.

Но, в этом кейсе меня смущает то, что по кускам текста с нового домена, который использует тексты старого, я нахожу дорвеи.

И наш новый "более трастовый" expired домен попал в скрытые результаты.

Если на ваших сайтах такой проблемы нет сегодня, это не значит, что она не возникнет завтра. И, как я уже писал в первой части статьи, под раздачу попали и хорошие сайты, которые продвигались исключительно белыми методами.

Давай брат, пиши свежие статьи для моих доров

Таким образом, возникает ряд вопросов:

- Не являются ли эти дорвейные сайты, которые скопировали тексты исходного домена настоящей причиной дропа трафика? И если это так, можно ли было решить проблему не переезжая на новый домен?

- Что произошло в Google такого, что во многих случаях дорвеи стали первоисточником?

- Как долго продлится такая ситуация? Что делать нормальным сайтам?

- Как защититься и как с этим бороться, ведь Google не реагирует на частичное копирование документов в большинстве случаев.

- Что делать многостраничным сайтам?

Я попробовал сделать выводы в прошлой части, но с удовольствием послушаю ваши мысли в этой.

Автор статьи: Дмитрий Сохач, co-founder at AdmixGlobal

Канал @AmazonPartnerka

Другие статьи:

2872

2872