|

Важность: высокая

Описание ошибки «Редирект, заблокированный в Robots.txt»

Показывает адреса страниц, возвращающие перенаправление на URL, который заблокирован в файле robots.txt. Обратите внимание: в отчёте будут отображены все URL из цепочки редиректов, которые ведут на заблокированный адрес.

Важность проблемы

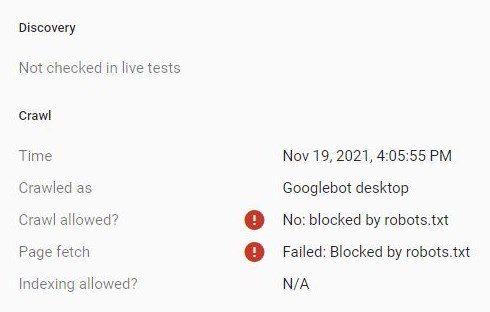

Редирект, заблокированный в robots.txt, возникает, когда первый URL доступен для сканирования, а конечный адрес редиректа или любой другой URL в цепочке перенаправления закрыты. В таком случае поисковый робот переходит по ссылке, но не может продолжить сканирование, потому что попадает на заблокированный для него адрес.

Такие перенаправления отрицательно влияют на сканирование сайта поисковыми роботами и расходуют ссылочный вес. Из-за этого важные страницы сайта могут получить меньше ссылочного веса и меньший приоритет для поискового робота → следовательно, реже сканироваться, получать низкие позиции в поиске и приносить меньше трафика, чем могли бы.

Пути исправления ошибки

Стоит убрать с сайта внутренние ссылки на редиректы или заменить ссылками на доступные страницы.

После этого нужно перепроверить настройки перенаправления: возможно, были допущены ошибки в конечном URL редиректа. Если ошибки нет, стоит закрыть в robots.txt начальный URL редиректа, чтобы поисковый робот не заходил на него.

Проверить качество оптимизации страницы можно с помощью бесплатного браузерного расширения SiteAnalyzer SEO Tools.

|