Всем привет! Мы снова с вами!

Сегодня мы презентуем версию SiteAnalyzer 2.0, чему несказанно рады! А все потому, что в версии 2.0 мы добавили визуализацию структуры сайта на графе (визуализация ссылочных связей, аналогично как это делает Screaming Frog SEO Spider), а также провели работу над устранением ошибок прошлых версий, которые мешали продуктивной работе.

Надеемся, что и для вас новая версия SiteAnalyzer окажется незаменимым помощником в продвижении, оптимизации и улучшении ваших проектов!

Основные изменения

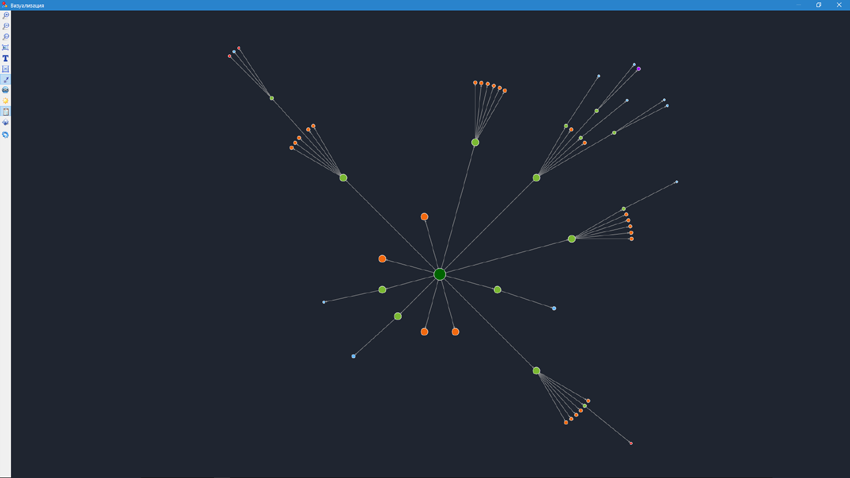

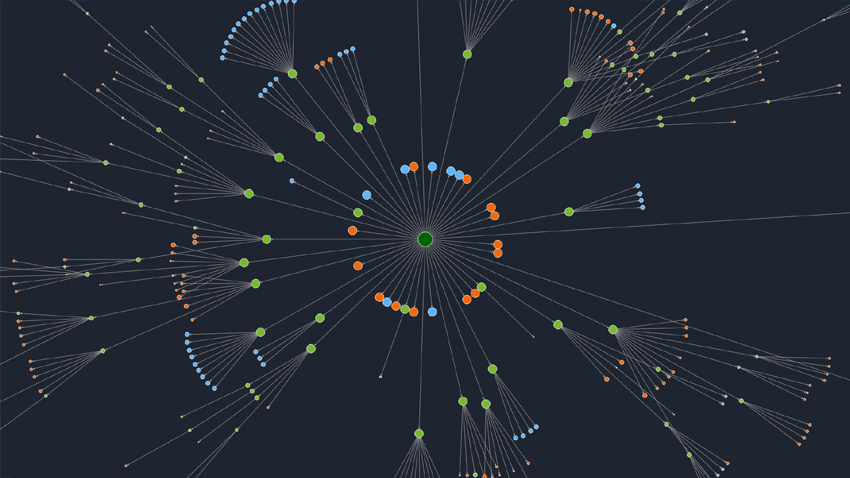

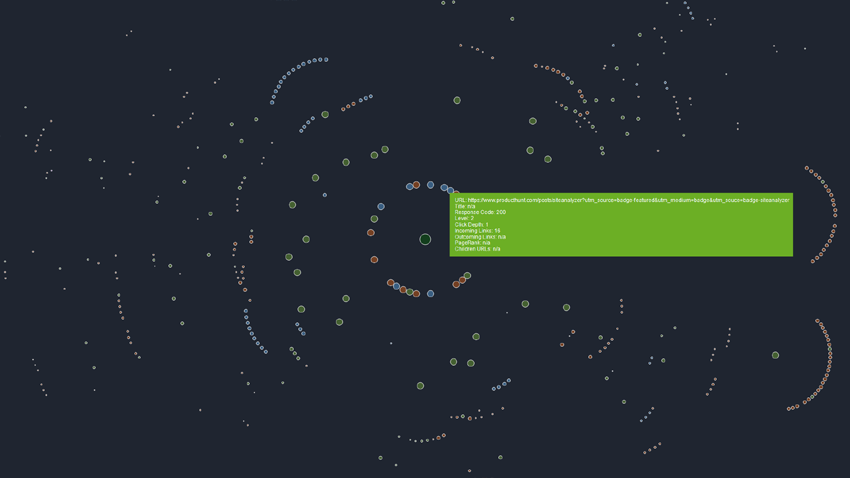

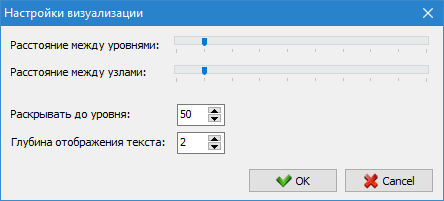

1. Добавлена визуализация структуры сайта на графе.

- Режим визуализации ссылочных связей на графе поможет SEO-специалисту оценить распределение внутреннего PageRank на страницах сайта, а также понять, какие из страниц получают большую ссылочную массу (и соответственно, больший внутренний ссылочный вес в глазах поисковых систем), а каким страницам и разделам сайта не хватает внутренних ссылок.

- Таким образом, при помощи режима визуализации структуры сайта SEO-специалист сможет наглядно оценить то, как организована внутренняя перелинковка на сайте, а также за счет визуального представления массы PageRank, присвоенной тем или иным страницам, оперативно вносить корректировки в текущую перелинковку сайта и тем самым повышать релевантность интересующих страниц.

2. Добавлена возможность сканирования сайтов по внутренним URL.

- В прошлых версиях сканирование сайта всегда начиналось с главной страницы вне зависимости от добавляемого URL, поэтому какой бы URL не был добавлен в программу: внутренний или внешний, сканирование сайта всегда начиналось от его корня.

- Начиная с версии 2.0 сканирование новых сайтов будет происходить относительно добавляемого URL, а не только по главной странице сайта, как было ранее.

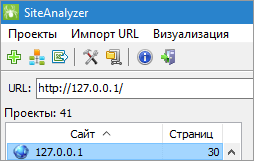

3. Добавлена возможность сканирования локальных сайтов.

- Теперь можно сканировать адреса сайтов, работающих на стационарных компьютерах под управлением локального веб-сервера Denwer, Live Server и им подобных (например, можно просканировать сайт по локальному адресу http://127.0.0.1:5500/ и т.п.).

4. Добавлено автоматическое пересканирование страниц, если их скачивание завершается таймаутом.

- При сканировании сайтов порой встречается такая ситуация, когда администратор сайта устанавливает защиту от излишне частых обращений к своему веб-ресурсу (например, для защиты сайтов от DDoS атак), в результате чего сайт блокирует большое количество одновременных внешних запросов к нему и возвращает неопределенные коды ответа, по которым невозможно получить данные ни о типе скачиваемого контента, ни сам контент.

- Поэтому нами было добавлено автоматическое пересканирование страниц, если их скачивание завершается таймаутом сервера. В результате этого, если одна из страниц при скачивании получила в ответ вместо контента ошибку таймаута сервера, то такая страница будет поставлена в очередь и пересканирована еще раз.

5. Оптимизировано управление скоростью скачивания и записью данных в базу.

- Теперь сохранение данных в базу не будет таким долгим при большом количестве потоков сканирования, так как в алгоритме сканера стал соблюдаться баланс между скоростью скачивания страниц и скоростью записи данных в базу.

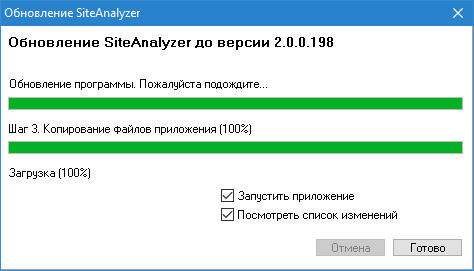

6. Добавлена возможность автоматического обновления версий программы.

- Каждый раз при запуске программа проверяет наличие новой версии на сервере, и если таковая имеется, предлагает обновить версию в автоматическом режиме без необходимости пользователя вручную скачивать архив и обновлять файлы программы.

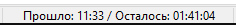

7. Добавлен счетчик оставшегося времени сканирования текущего проекта.

- Счетчик отображает прогноз длительности сканирования исходя из текущей скорости сканирования и количества ссылок в очереди.

Прочие изменения

- Добавлена возможность копирования текста из поля ввода URL по Ctrl-C.

- Восстановлена возможность сканирования больших массивов ссылок при импорте URL из файла, буфера обмена, либо по ссылке.

- Восстановлена проверка индексации страниц через сервис Яндекс XML.

- Исправлен баг с некорректным ответом сервера при парсинге страниц, содержащих в URL знак плюс (+).

- Исправлен некорректный экспорт структуры сайта в CSV (число страниц сайта выгружалось не полностью).

- Исправлен некорректный учет содержимого тега BASE при парсинге страниц (когда BASE HREF представлял собой домен).

- Исправлен баг, возникающий при удалении произвольных строк сразу после сканирования проекта (также добавлено удаление URL по кнопке Delete).

- Исправлен баг, при котором сканер учитывал содержимое мета-тегов "noindex, nofollow" при отключении данной опции в настройках программы.

- Исправлен баг, при котором не отображалась область выделенного диапазона ячеек при потере курсора в таблице с основными данными.

https://t.me/siteanalyzer

Новости прошлых версий:

11,962

11,962